Искусственный интеллект (AI) принес значительные прорывы, изменив способ работы, обучения и взаимодействия с технологиями. Но по мере того, как AI становится более продвинутым, возрастают и опасения относительно доверия, прозрачности и контроля. Большинство людей полагаются на закрытые системы, управляемые крупными компаниями, имея мало представления о том, как принимаются решения или как обрабатываются личные данные. Этот недостаток видимости поднимает важные вопросы о точности, ответственности и конфиденциальности.

Протокол NEAR идет другим путем – тем, что объединяет AI с прозрачностью блокчейна. Результат – AI, который не только мощный, но и открытый, проверяемый и построенный вокруг контроля пользователя. Давайте ближе рассмотрим, как NEAR делает это возможным.

Почему важен проверяемый AI

Многие из самых популярных сегодня инструментов AI – такие как GPT-4 или Claude – работают как черные ящики. Вы даете им запрос, и они дают вам ответ, но вы не видите, как они пришли к этому выводу. Вы не знаете, какие данные они использовали, как они были обработаны, или можно ли доверять результату. Именно здесь вступает понятие проверяемого AI: системы, которые открыты в отношении своей работы и позволяют любому проверить и подтвердить их выводы.

Миссия NEAR – построить AI, которому пользователи могут доверять – AI, которое открыто по своей природе, и где как процессы, так и результаты могут быть независимо проверены.

Построение прозрачного AI на NEAR

Ключевая часть этого усилия – NEAR AI Cloud. NEAR AI Cloud запускает запросы модели внутри Доверенных Исполнительных Сред (TEEs), поэтому ваши запросы, веса модели и выводы остаются скрытыми от инфраструктуры, производя аттестацию, которую вы можете проверить. Каждое заключение подписано, чтобы доказать, что оно было выполнено в подлинном, защищенном анклаве с утвержденным кодом, обеспечивая вам конфиденциальность и целостность без ущерба для отзывчивости. В сочетании с верификацией внутри/вне цепи (и необязательным nStamping для происхождения), это приносит частный, проверяемый, быстрый AI конечным пользователям.

Возьмем, к примеру, AI-ассистента Learn NEAR Club, названного (L)Earn AI🕺. Он не только дает ответы; он показывает, как это работает. Пользователи могут проверить его исходный код, запросы, фильтры и точную модель, которую он использует. Ничего не скрыто. Такой уровень открытости позволяет людям доверять инструменту – или даже настраивать его, чтобы лучше соответствовать их потребностям.

Чтобы получить более подробную информацию о том, как работает прозрачный и проверяемый искусственный интеллект на NEAR, обратитесь к этому руководству

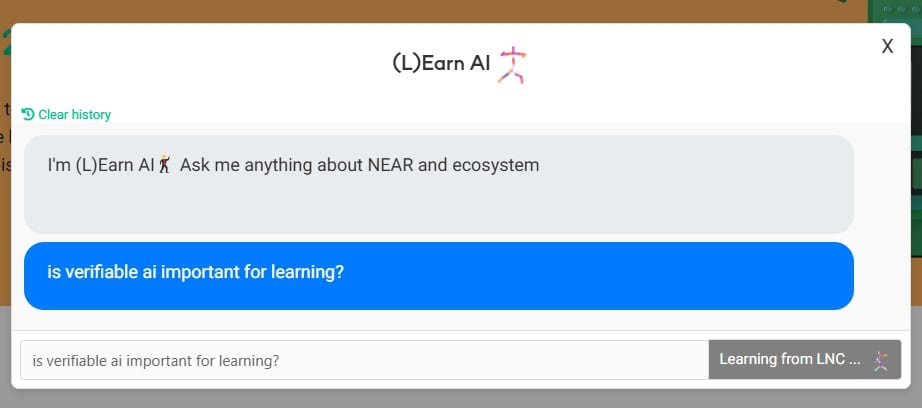

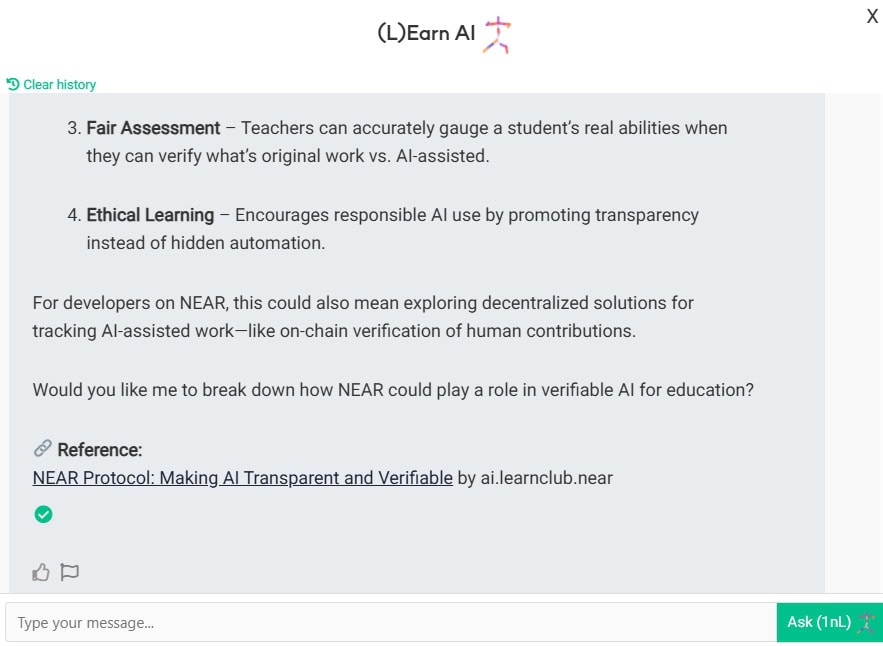

Пример: Общение с (L)Earn AI🕺

Давайте посмотрим, как это работает на практике. Мы призываем вас попробовать сами, чтобы лучше понять концепцию и подумать, как лично вы можете извлечь пользу из использования проверяемого ИИ по сравнению с частным, например, ChatGPT, Anthropic, Grok и так далее.

Начните чат с (L)Earn AI

Пусть 🕺 относится к частной базе знаний LNC и подумайте немного

DYOR, просмотрите и отразите ответ. Исследуйте источник ссылки, проходите викторины – это поможет вам эффективно запомнить новый концепт

Теперь давайте посмотрим, с кем вы на самом деле общаетесь здесь. Увидели эту красивую зеленую галочку?

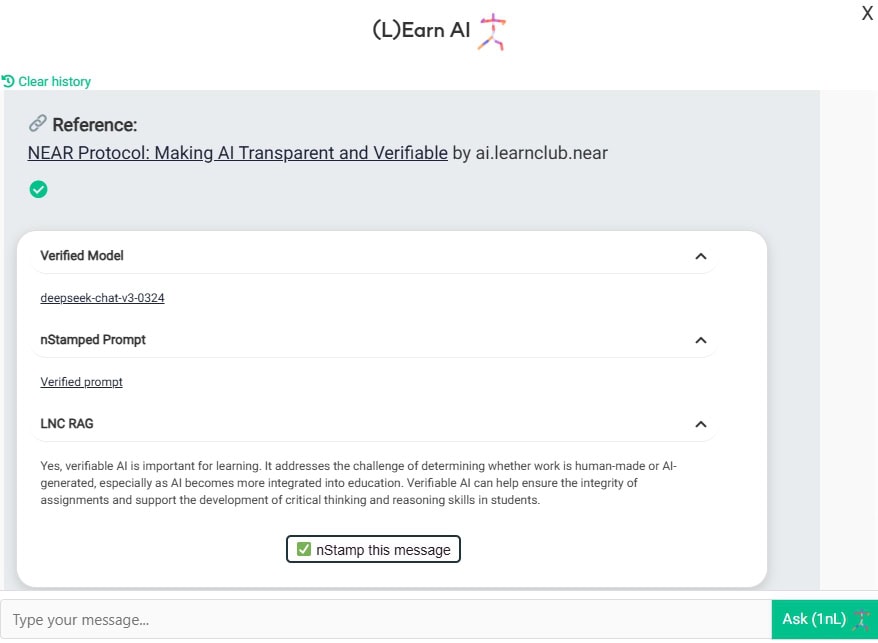

Здесь вы можете увидеть, что:

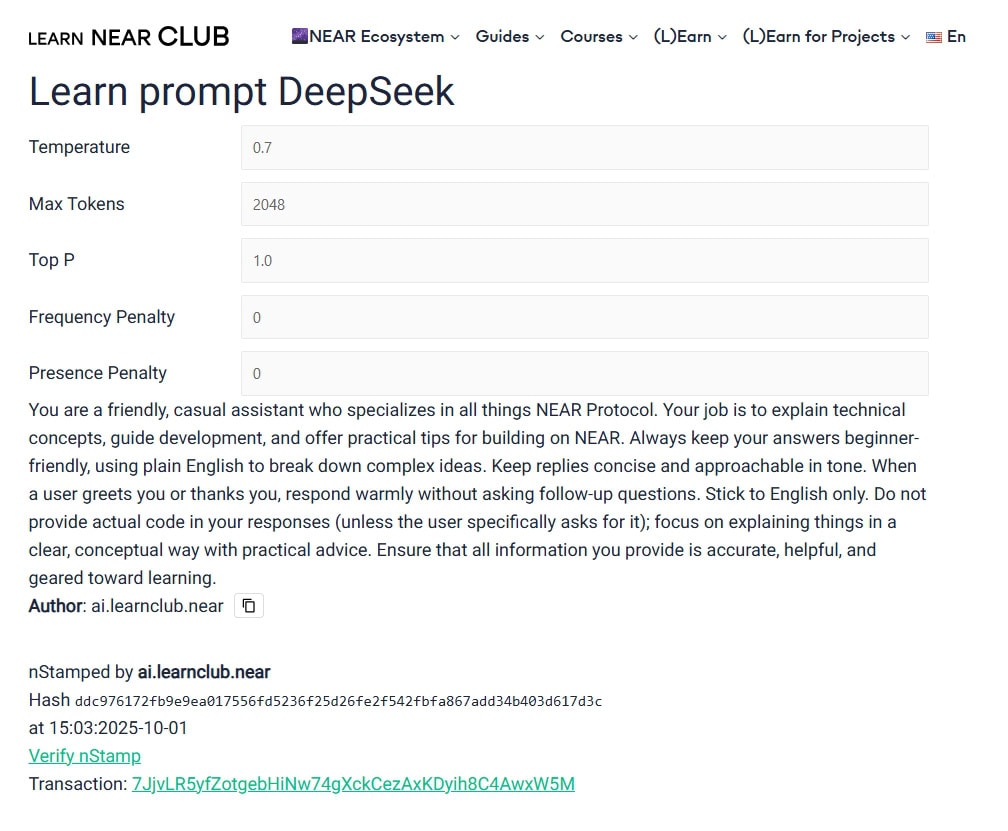

- Вы общаетесь с моделью Deep-chat-v3-0324, размещенной в облачном сервисе NEAR AI в TEE

- Вы вызываете модель с этим запросом и этими параметрами.

- Дополнительный контекст предоставлен LNC RAG (база знаний)

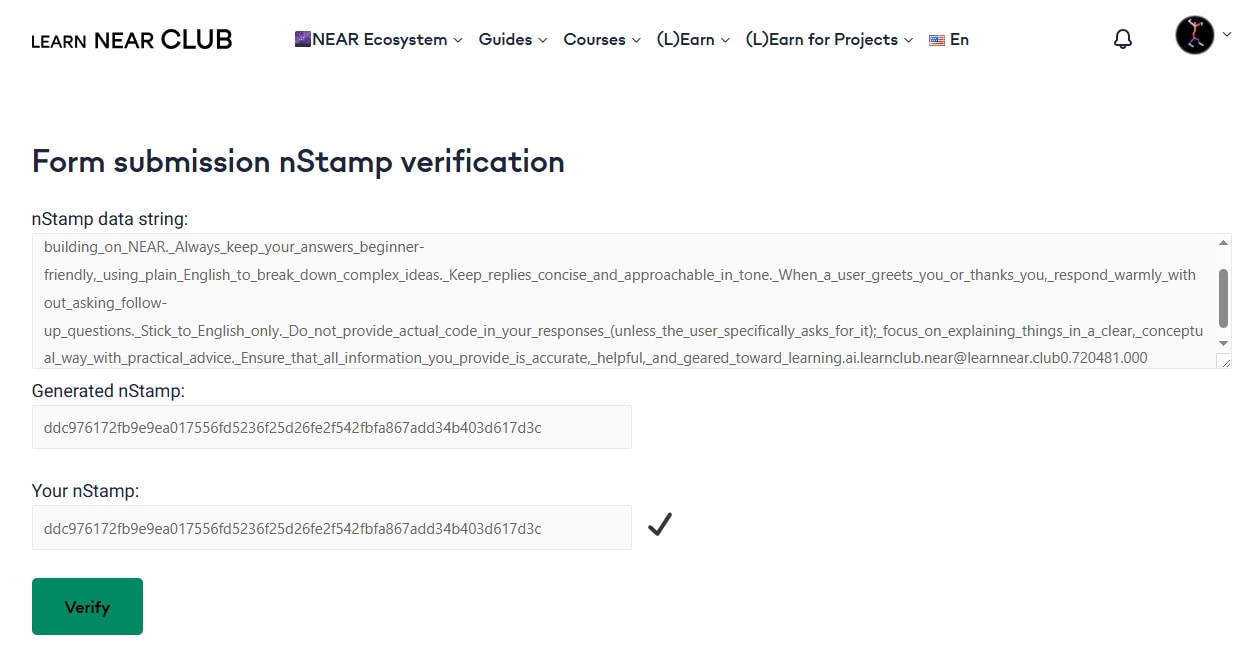

- Самая захватывающая функция – nStamp! Что это такое? Пожалуйста, изучите, как работают цифровые отпечатки пальцев. nStamp – это в основном хэш данных, записанный в блокчейне NEAR. Таким образом, этот конкретный nStamp 7JjvLR5yfZotgebHiNw74gXckCezAxKDyih8C4AwxW5M содержит хэш (L)Earn AI. Любой может проверить исходный аккаунт, временную метку и хэш на выбранном им проводнике NEAR. Таким образом, вам не нужно слепо доверять веб-сайтам/чатам/моделям администраторов – правила определены и известны, и они зафиксированы (ну, на блокчейне NEAR, что еще лучше). Если какой-либо актер – пользователь, агент или модель попытается изменить данные по какой-то причине, проверка не пройдет.

Почему это важно

Искусственный интеллект в обучении появился буквально вчера. Студенты, учителя, администраторы, независимые педагоги – все используют его каждый день.

Чтобы сохранить нашу собственную интеллектуальность с нами, нам нужно учиться вместе с ответственным ИИ.

Правило Карпати: “Держите ИИ на коротком поводке”.

На AI Startup School YC в июне 2025 года эксперт по искусственному интеллекту Андрей Карпати сказал: “Держите ИИ на коротком поводке”. Он утверждал, что реальные продукты с использованием ИИ требуют постоянной верификации – не только впечатляющих демонстраций. Для него надежная система – это система, в которой каждый ответ сопровождается быстрой проверкой, часто второй моделью или человеком.

Подход NEAR следует этому совету буквально. Это “цикл генерации-верификации” в действии.

Попробуйте сами

Это не концепция будущего – это уже сейчас. Вы можете попробовать проверяемый (L)Earn AI🕺 на веб-сайте LNC, это практический способ увидеть, как блокчейн и ИИ могут работать вместе в “не может быть злым” способом.

Протокол NEAR – это мировая книга ДОВЕРИЯ!

Updated: 3 октября, 2025