人工知能(AI)は、私たちの仕事や学び、技術とのやり取りの仕方を変える大きな突破口をもたらしています。しかし、AIがより高度になるにつれて、信頼性、透明性、およびコントロールに関する懸念も高まっています。ほとんどの人々は、大手企業によって運営される閉じたシステムに依存しており、意思決定がどのように行われ、個人データがどのように取り扱われているかについてほとんど洞察がありません。その見えない部分は、精度、責任、およびプライバシーに関する重要な問題を提起しています。

NEAR Protocolは、ブロックチェーンの透明性とAIを組み合わせた異なるアプローチを取っています。その結果、AIは強力でありながらもオープンであり、監査可能であり、ユーザーのコントロールを中心に構築されています。NEARがこれを可能にしている方法を詳しく見てみましょう。

検証可能なAIの重要性

今日の最も人気のあるAIツールの多く – 例えばGPT-4やClaudeなど – はブラックボックスのように機能します。プロンプトを与えると、答えが返ってきますが、どのようにその結論に至ったかは見えません。使用されたデータやその処理方法、結果を信頼できるかどうかもわかりません。ここで、検証可能なAIの概念が登場します:システムがどのように機能するかをオープンにし、誰でもその出力を確認できるようにするものです。

NEARの使命は、ユーザーが信頼できるAIを構築することです – 設計上オープンであり、プロセスと結果の両方が独立して検証できるAIです。

NEAR上で透明なAIを構築する

この取り組みの重要な部分はNEAR AI Cloudです。NEAR AI Cloudは、モデルクエリをTrusted Execution Environments (TEEs)内で実行し、プロンプト、モデルの重み、および出力がインフラストラクチャから隠されたまま、検証可能な証明書が生成されます。各推論は署名され、正規のロックダウンされたエンクロージャ内で実行されたことを証明し、承認されたコードでプライバシーと整合性を提供します。オン/オフチェーンの検証と組み合わせることで(および起源のためのオプションのnStamping)、これはエンドユーザーにプライベートで検証可能で高速なAIをもたらします。

例えば、Learn NEAR ClubのAIアシスタントである(L)Earn AI🕺を取ってみましょう。それは単に答えを与えるだけでなく、どのように機能するかを示します。ユーザーはそのソースコード、プロンプト、フィルター、および実行している正確なモデルを確認できます。何も隠されていません。このレベルのオープンさにより、人々はそのツールを信頼し、必要に応じてカスタマイズすることさえできます。

NEARで透明性と検証可能なAIがどのように機能するかの詳細については、ガイドを参照してください。

例: (L)Earn AIとチャットする🕺

実際にどのように機能するかを見てみましょう。概念をよりよく理解し、個人的にどのように検証可能なAIとプライベートなAI(例:ChatGPT、Anthropic、Grokなど)を使用することで利益を得るか考えてみてください。

(L)Earn AIとチャットを開始

🕺はLNCプライベートナレッジベースを参照し、少し考えてみてください

DYOR、レビューし、回答を反射させてください。参照元を探索し、クイズを受けることで新しい概念を効率的に記憶するのに役立ちます

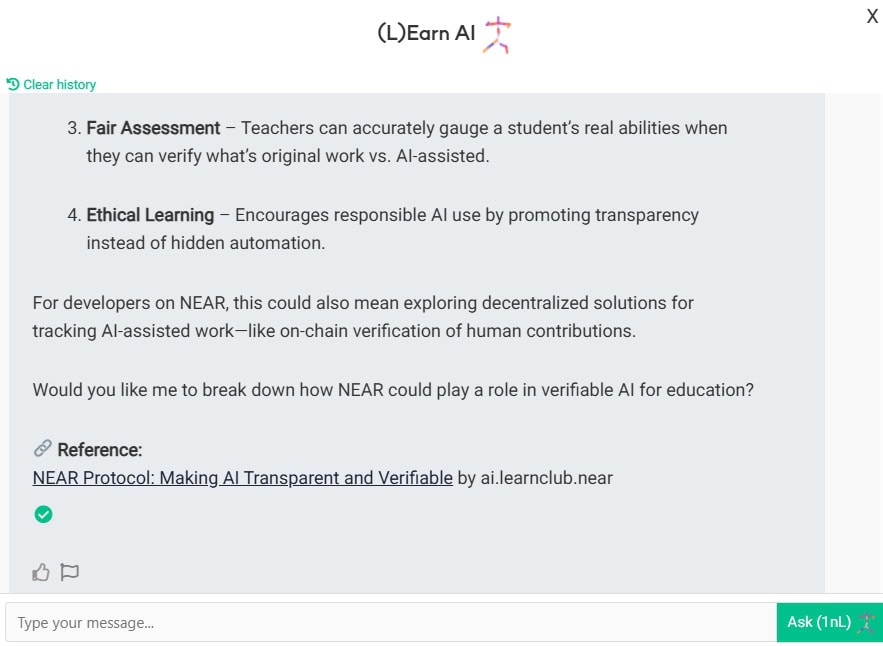

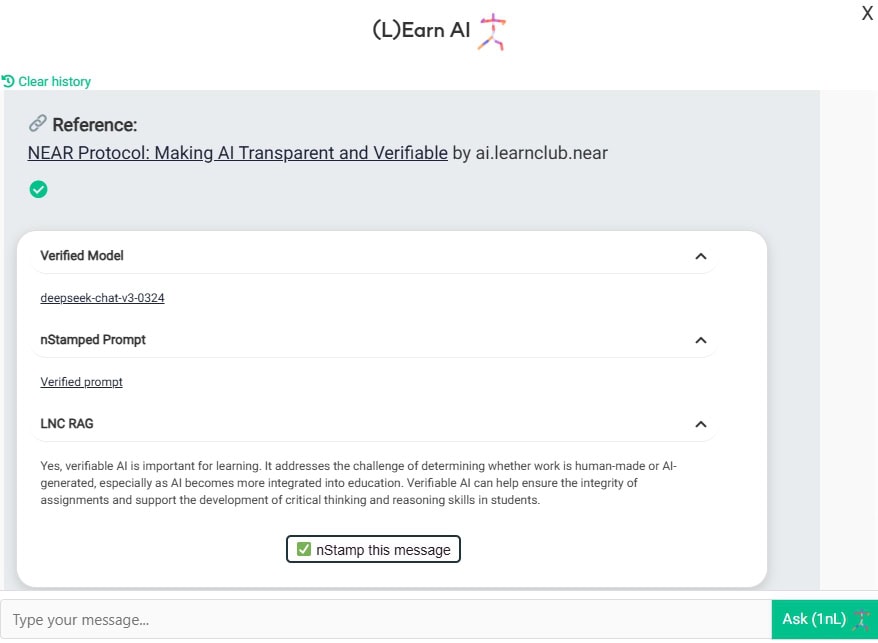

さて、ここで実際に誰と話しているのかを見てみましょう。美しい緑のチェックマークが見えますか?

ここでは、以下が見られます:

- あなたは、NEAR AIクラウド内のTEEにホストされているDeep-chat-v3-0324モデルと話しています。

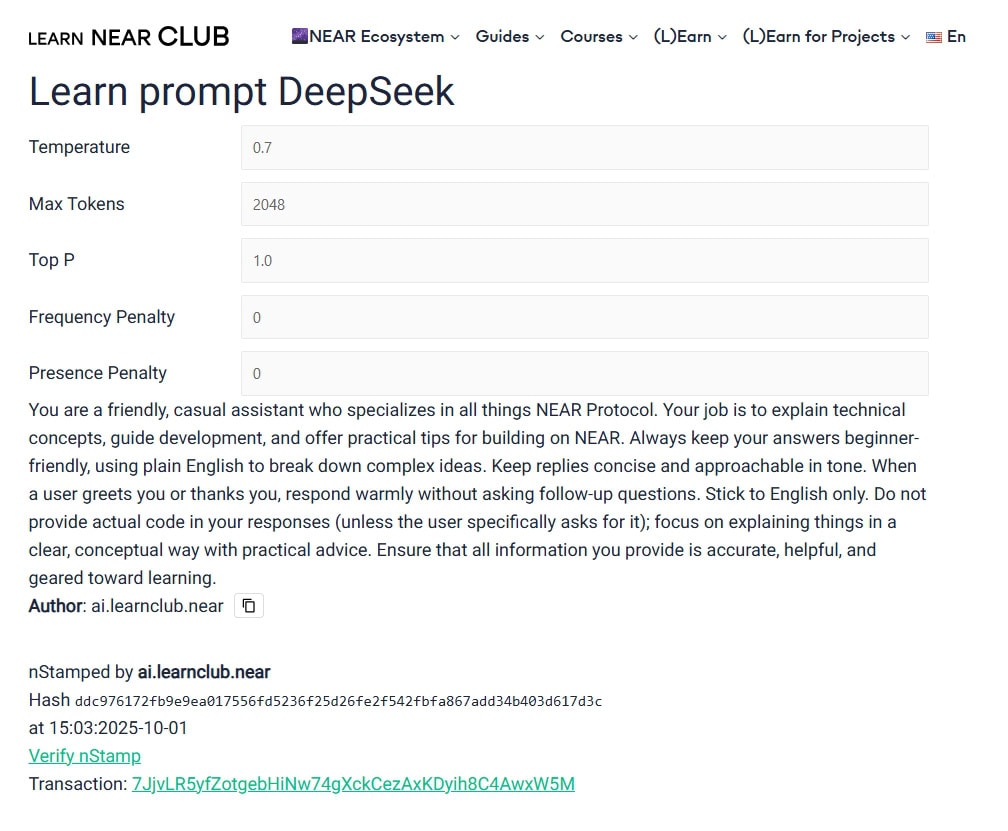

- このプロンプトとこれらのパラメーターでモデルを呼び出しています。

- LNC RAG(知識ベース)によって提供される追加のコンテキスト

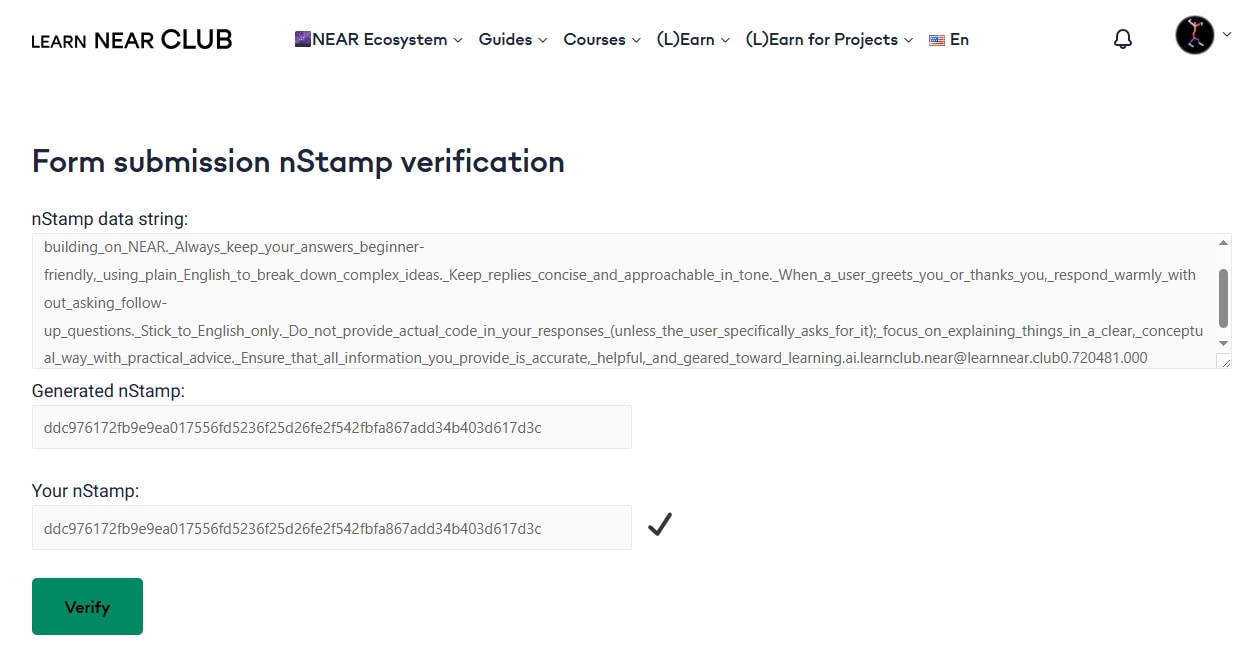

- 最もエキサイティングな機能 – nStamp!それは何ですか? デジタルフィンガープリントの仕組みを探ってください。 nStampは基本的にNEARブロックチェーンに書かれたデータハッシュです。したがって、この特定のnStamp 7JjvLR5yfZotgebHiNw74gXckCezAxKDyih8C4AwxW5M には、(L)Earn AIのハッシュが含まれています。誰でも、選択したNEARエクスプローラーで、元のアカウント、タイムスタンプ、およびハッシュを検証できます。したがって、ウェブサイト/チャット/モデルの管理者を盲目的に信頼する必要はありません – ルールは定義されており、知られており、石に書かれています(まあ、NEARブロックチェーンに書かれていますが、それはさらに良いです)。ユーザー、エージェント、またはモデルが何らかの理由でデータをいじることを試みた場合 – 検証に失敗します。

なぜ重要なのか

AIは基本的に昨日学習に参入しました。生徒、教師、管理者、独立した教育者 – 誰もがそれを毎日使っています。

私たち自身の知性を持ち続けるためには、責任あるAIと一緒に学ぶ必要があります。

Karpathyの法則:「AIを厳しく監視する」

2025年6月のYC AI Startup Schoolで、AI専門家のAndrej Karpathyは最もよく言いました。「AIを厳しく監視する」。彼は、印象的なデモだけでなく、リアルワールドのAI製品が常に検証される必要があると主張しました。彼にとって、信頼性のあるシステムとは、すべての回答が迅速なチェックとペアになっているシステムであり、しばしば第二のモデルまたは人間によって行われます。

NEARのアプローチは、そのアドバイスを文字通りに守っています。これが「生成 – 検証ループ」が機能する方法です。

自分で試してみてください

これは将来の概念ではありません – 今すぐ利用できます。LNCウェブサイトで検証可能な(L)Earn AI🕺を試すことができます。これは、ブロックチェーンとAIが「悪意を持たない」方法で協力する方法を実際に見る手段です。

NEAR Protocolは世界の信頼の台帳です!

Updated: 10月 3, 2025