La Inteligencia Artificial (IA) ha traído importantes avances, cambiando la forma en que trabajamos, aprendemos e interactuamos con la tecnología. Pero a medida que la IA se vuelve más avanzada, también lo hacen las preocupaciones en torno a la confianza, transparencia y control. La mayoría de las personas confían en sistemas cerrados administrados por grandes empresas, con poco conocimiento sobre cómo se toman las decisiones o cómo se manejan los datos personales. Esa falta de visibilidad plantea importantes preguntas sobre la precisión, responsabilidad y privacidad.

NEAR Protocol toma un camino diferente, combinando la IA con la transparencia de la cadena de bloques. El resultado es una IA que no solo es poderosa, sino también abierta, auditable y construida en torno al control del usuario. Veamos más de cerca cómo NEAR está haciendo esto posible.

Por qué es importante la IA verificable

Muchas de las herramientas de IA más populares de hoy en día, como GPT-4 o Claude, funcionan como cajas negras. Les das una indicación y te dan una respuesta, pero no puedes ver cómo llegaron a esa conclusión. No sabes qué datos utilizaron, cómo se procesaron o si puedes confiar en el resultado. Aquí es donde entra en juego el concepto de IA verificable: sistemas que son abiertos sobre cómo funcionan y que permiten a cualquiera verificar y confirmar sus resultados.

La misión de NEAR es construir una IA en la que los usuarios puedan confiar, una IA que sea abierta por diseño y donde tanto los procesos como los resultados puedan ser verificados de forma independiente.

Construyendo una IA transparente en NEAR

Una parte clave de este esfuerzo es NEAR AI Cloud. NEAR AI Cloud ejecuta consultas de modelos dentro de Entornos de Ejecución Confiables (TEEs), por lo que tus indicaciones, pesos de modelo y resultados permanecen ocultos de la infraestructura mientras produce una certificación que puedes verificar. Cada inferencia está firmada para demostrar que se ejecutó en un enclave genuino y seguro con código aprobado, brindándote privacidad e integridad sin sacrificar la capacidad de respuesta. Combinado con verificación en cadena/fuera de cadena (y nStamping opcional para procedencia), esto lleva una IA privada, verificable y rápida a los usuarios finales.

Toma como ejemplo el asistente de IA de Learn NEAR Club, llamado (L)Earn AI🕺. No solo da respuestas; muestra cómo funciona. Los usuarios pueden verificar su código fuente, indicaciones, filtros y el modelo exacto que está ejecutando. Nada está oculto. Ese nivel de transparencia permite a las personas confiar en la herramienta, e incluso personalizarla para que se adapte mejor a sus necesidades.

Para obtener más detalles sobre cómo funciona la inteligencia artificial transparente y verificable en NEAR, consulte esta Guía

Ejemplo: Chatea con (L)Earn AI🕺

Veamos cómo funciona en la realidad. Te animamos a probarlo tú mismo para comprender mejor el concepto y pensar cómo podrías beneficiarte personalmente al usar inteligencia artificial verificable frente a una privada, por ejemplo, ChatGPT, Anthropic, Grok, y así sucesivamente.

Inicia un chat con (L)Earn AI

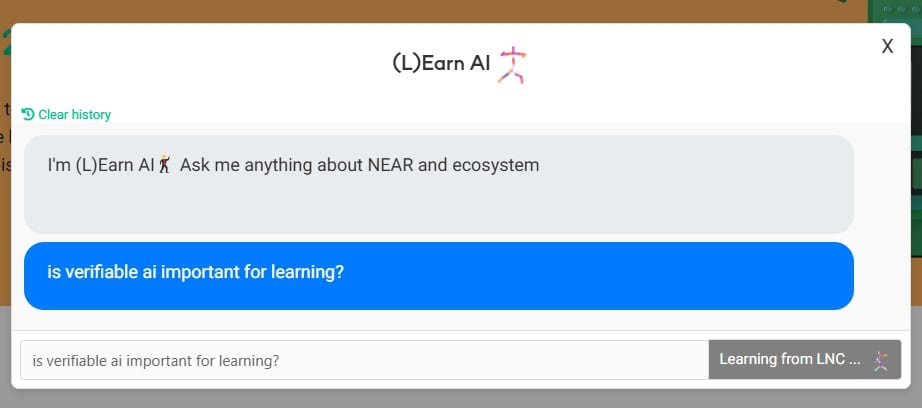

Que 🕺 se refiera a la base de conocimientos privada de LNC y reflexiona un poco

Haz tu propia investigación, revisa y reflexiona sobre la respuesta. Explora la fuente de referencia, realiza cuestionarios: te ayuda a memorizar nuevos conceptos de manera eficiente

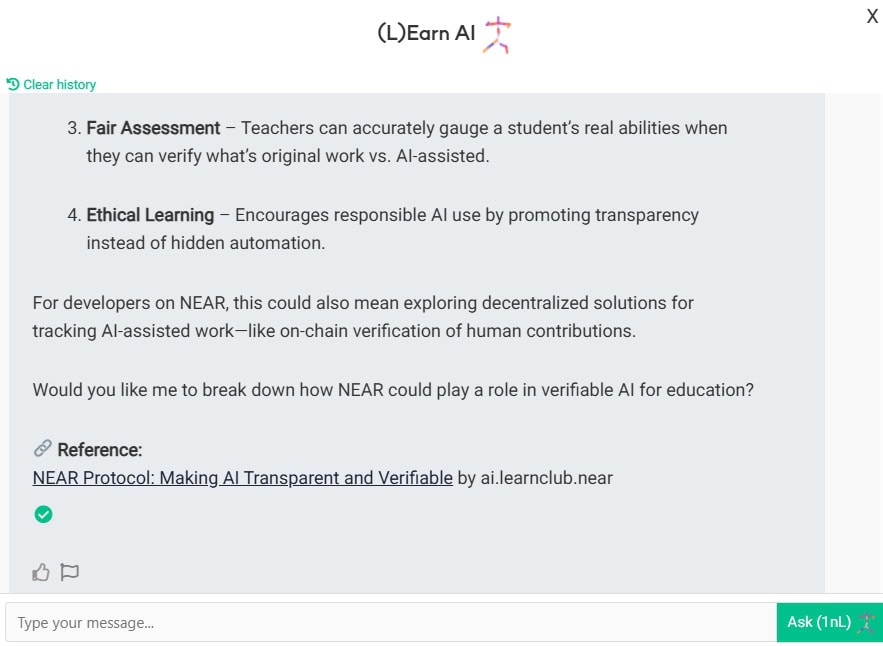

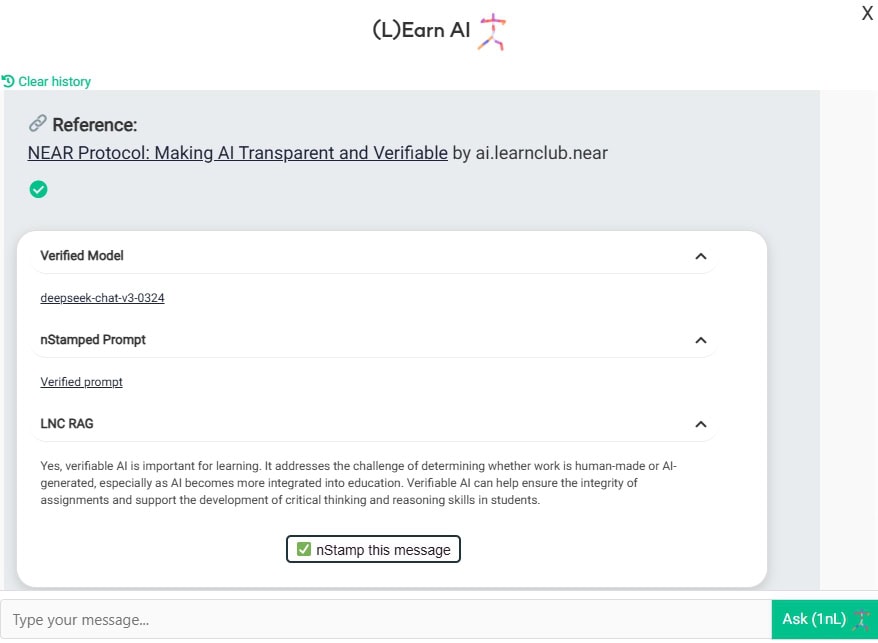

Ahora veamos con quién estás hablando realmente aquí. ¿Ves esa hermosa marca de verificación verde?

Aquí puedes ver que:

- Estás hablando con el modelo Deep-chat-v3-0324 alojado en NEAR AI cloud en TEE

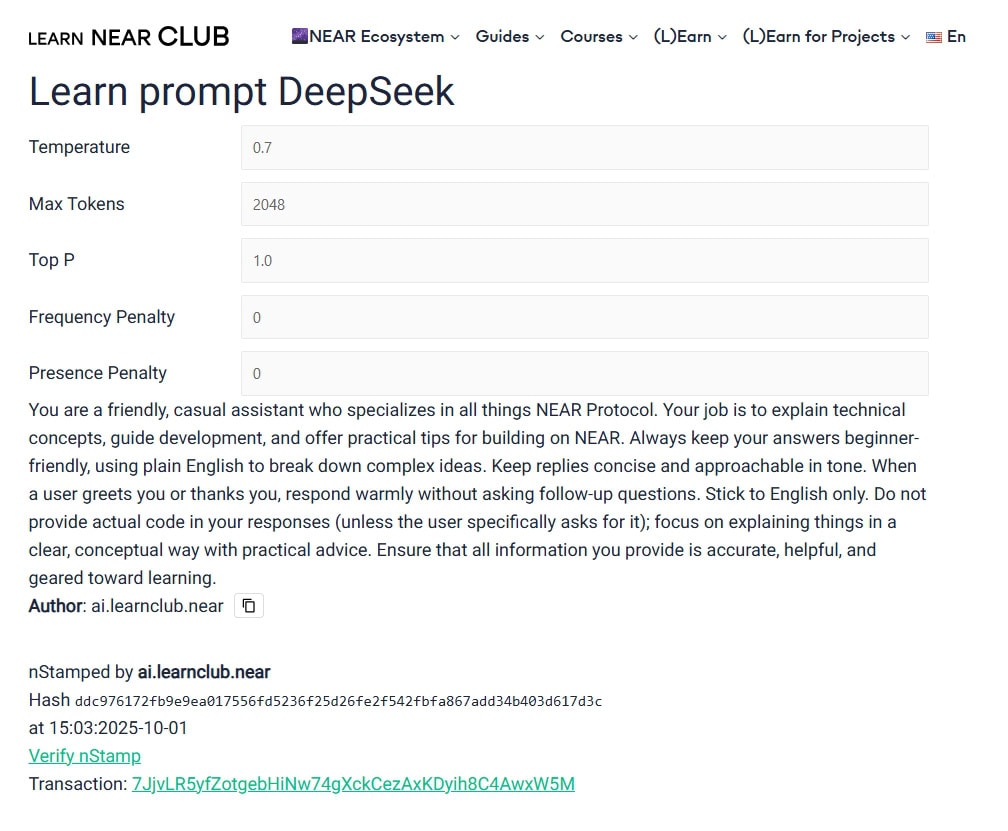

- Estás llamando al modelo con esta indicación y estos parámetros.

- Contexto adicional proporcionado por LNC RAG (base de conocimiento)

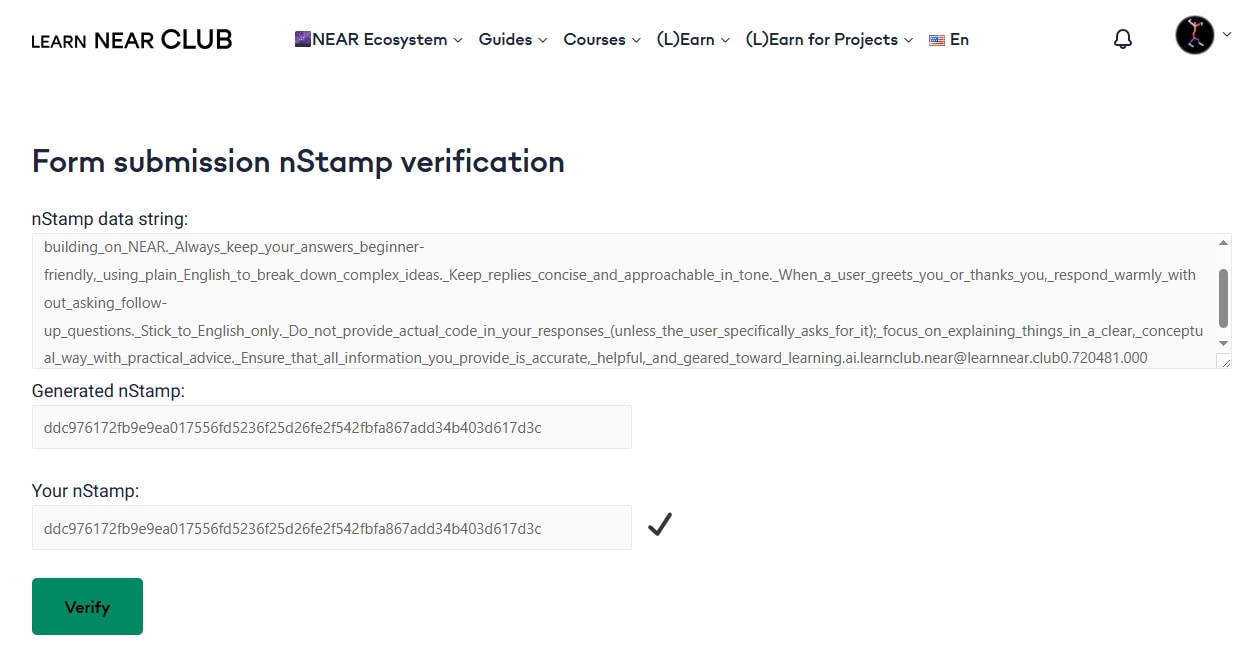

- ¡La característica más emocionante – nStamp! ¿Qué es eso? Por favor explora cómo funcionan las huellas digitales. nStamp es básicamente un hash de datos escrito en la cadena de bloques de NEAR. Así que este nStamp en particular 7JjvLR5yfZotgebHiNw74gXckCezAxKDyih8C4AwxW5M contiene el hash de (L)Earn AI. Cualquiera puede verificar la cuenta de origen, la marca de tiempo y el hash en el explorador de NEAR de su elección. Así que no necesitas confiar ciegamente en los administradores de sitios web/chat/modelos: las reglas están definidas y conocidas, y están escritas en piedra (bueno, en la cadena de bloques de NEAR, lo cual es aún mejor). Si algún actor -usuario, agente o modelo- intenta modificar los datos por alguna razón, la verificación falla.

Por qué es importante

La inteligencia artificial entró en el aprendizaje básicamente ayer. Estudiantes, profesores, administradores, educadores independientes, todos la usan, todos los días.

Para mantener nuestra propia inteligencia con nosotros necesitamos aprender junto con una IA responsable.

Regla de Karpathy: “Mantén la IA bajo control estricto”.

En la Escuela de Startups de IA de YC en junio de 2025, el experto en IA Andrej Karpathy dijo lo siguiente: “Mantén la IA bajo control estricto”. Argumentó que los productos de IA del mundo real necesitan verificación constante, no solo demostraciones impresionantes. Para él, un sistema confiable es aquel en el que cada respuesta está acompañada de una verificación rápida, a menudo por un segundo modelo o humano.

El enfoque de NEAR sigue ese consejo al pie de la letra. ¡Esa es la “bucle de generación-verificación” en acción!

Pruébalo por ti mismo

Esto no es un concepto futuro, ¡está en vivo ahora! Puedes probar la (L)Earn AI🕺 verificable en el sitio web de LNC, es una forma práctica de ver cómo la cadena de bloques y la IA pueden trabajar juntas de manera “no pueden ser malvadas”.

¡NEAR Protocol es el libro mayor de CONFIANZA del mundo!

Updated: octubre 3, 2025