A Inteligência Artificial (IA) trouxe grandes avanços, mudando como trabalhamos, aprendemos e interagimos com a tecnologia. Mas à medida que a IA se torna mais avançada, também aumentam as preocupações em torno da confiança, transparência e controle. A maioria das pessoas depende de sistemas fechados administrados por grandes empresas, com pouca visão sobre como as decisões são tomadas ou como os dados pessoais são tratados. Essa falta de visibilidade levanta questões importantes sobre precisão, responsabilidade e privacidade.

NEAR Protocol segue um caminho diferente – um que combina IA com a transparência da blockchain. O resultado é IA que não é apenas poderosa, mas também aberta, auditável e construída em torno do controle do usuário. Vamos dar uma olhada mais de perto em como a NEAR está tornando isso possível.

Por que a IA Verificável é Importante

Muitas das ferramentas de IA mais populares de hoje – como GPT-4 ou Claude – funcionam como caixas-pretas. Você dá a elas um comando, e elas te dão uma resposta, mas você não pode ver como chegaram a essa conclusão. Você não sabe quais dados foram usados, como foram processados, ou se pode confiar no resultado. É aqui que entra o conceito de IA verificável: sistemas que são transparentes sobre como funcionam e que permitem a qualquer um verificar e confirmar suas saídas.

A missão da NEAR é construir uma IA na qual os usuários possam confiar – uma IA que seja aberta por design, e onde tanto os processos quanto os resultados possam ser verificados de forma independente.

Construindo uma IA Transparente na NEAR

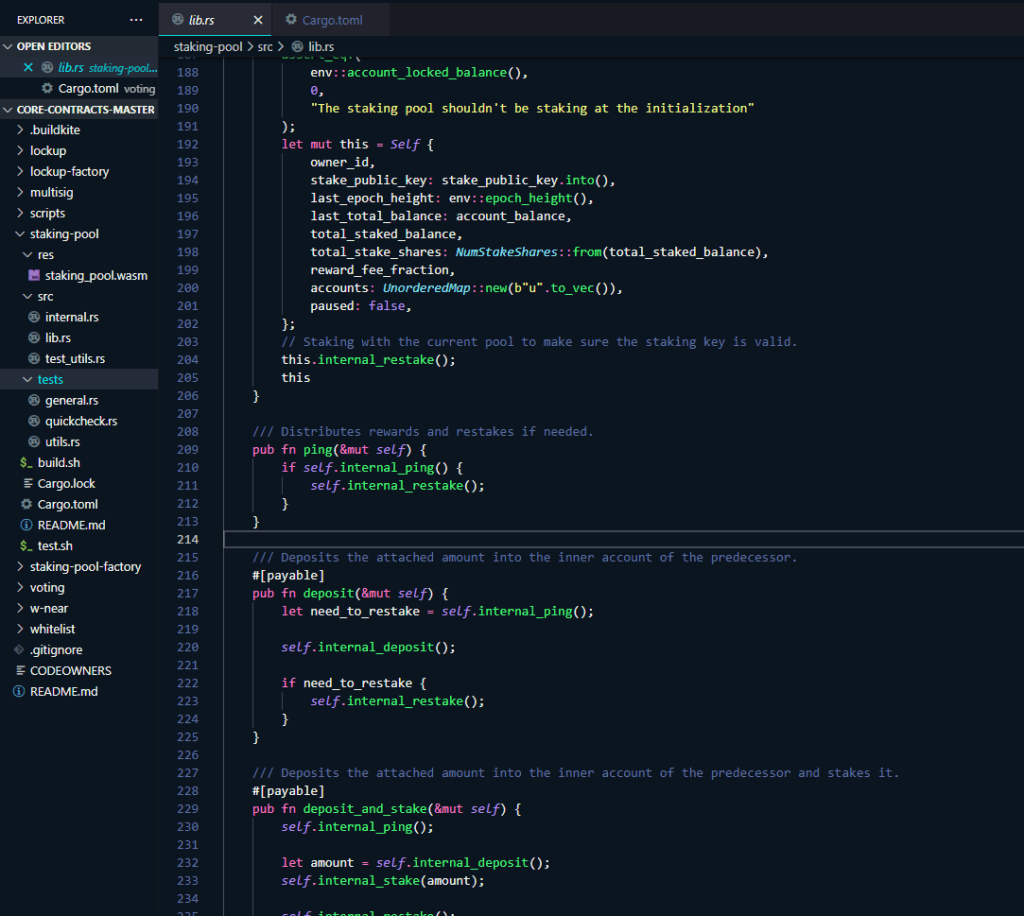

Uma parte fundamental desse esforço é a NEAR AI Cloud. A NEAR AI Cloud executa consultas de modelo dentro de Ambientes de Execução Confiáveis (TEEs), para que seus comandos, pesos do modelo e saídas permaneçam ocultos da infraestrutura enquanto produzem uma atestação que você pode verificar. Cada inferência é assinada para provar que foi executada em um enclave genuíno e seguro com código aprovado, proporcionando privacidade e integridade sem sacrificar a responsividade. Combinado com verificação on/off-chain (e nStamping opcional para procedência), isso traz uma IA privada, verificável, rápida para os usuários finais.

Pegue o assistente de IA do Learn NEAR Club, por exemplo – chamado (L)Earn AI🕺. Ele não apenas fornece respostas; ele mostra como funciona. Os usuários podem verificar seu código-fonte, comandos, filtros e o modelo exato que está sendo executado. Nada é oculto. Esse nível de transparência permite que as pessoas confiem na ferramenta – ou até mesmo personalizem para atender melhor às suas necessidades.

Para obter mais detalhes sobre como a IA transparente e verificável funciona na NEAR, consulte este Guia

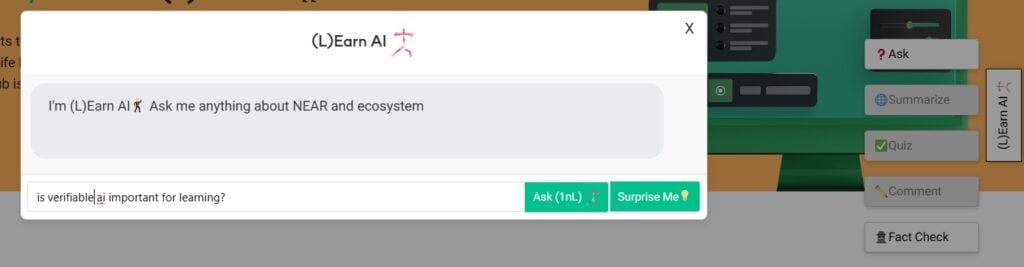

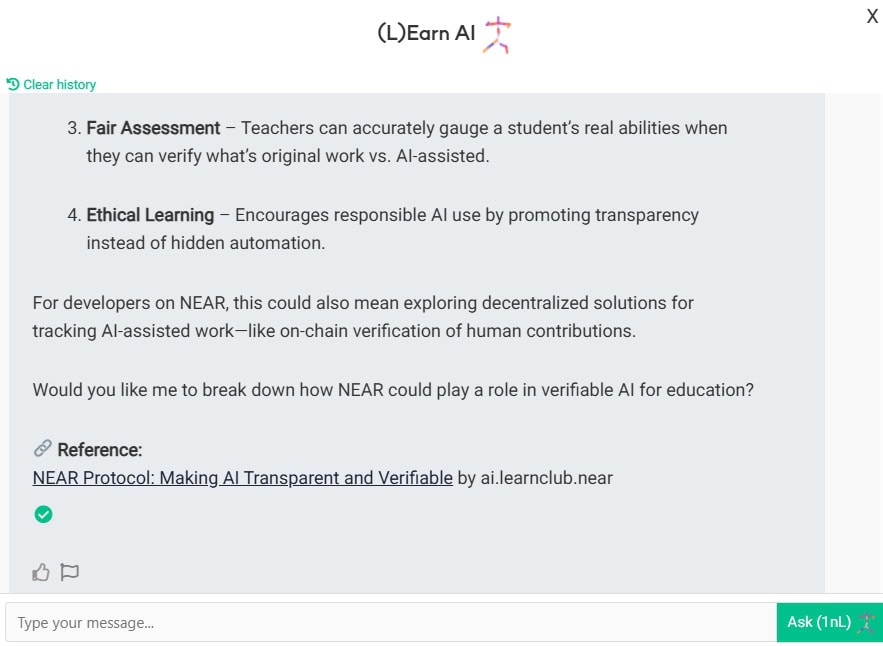

Exemplo: Conversar com (L)Earn AI🕺

Vamos ver como funciona na prática. Encorajamos você a experimentar por si mesmo para entender melhor o conceito e pensar em como você pessoalmente pode se beneficiar ao usar IA verificável em comparação com uma privada, por exemplo, ChatGPT, Anthropic, Grok e assim por diante.

Inicie uma conversa com (L)Earn AI

Deixe 🕺 referir-se à base de conhecimento privada LNC e pense um pouco

Faça sua própria pesquisa, avalie e reflita sobre a resposta. Explore a fonte de referência, faça quizzes – isso ajuda você a memorizar novos conceitos de forma eficiente

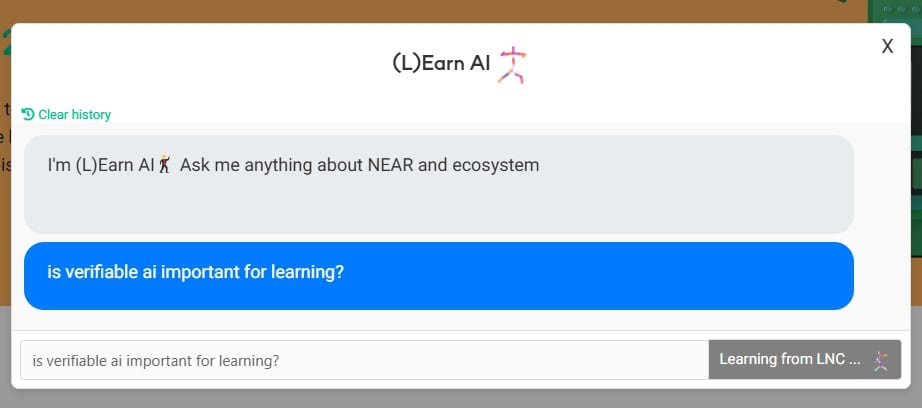

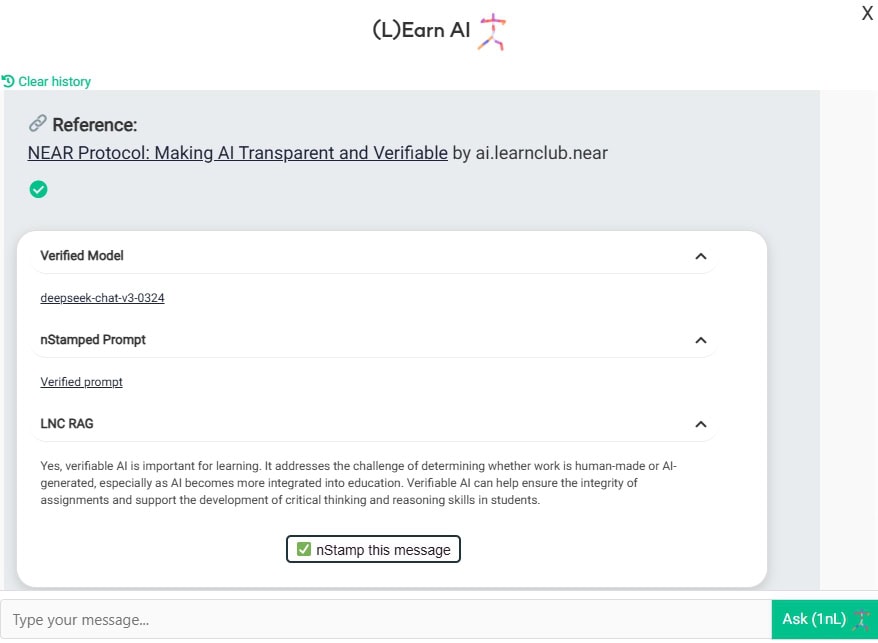

Agora vamos ver com quem você está realmente conversando aqui. Veja aquele belo visto verde?

Aqui você pode ver que:

- Você está conversando com o modelo Deep-chat-v3-0324 hospedado na nuvem de IA da NEAR em TEE

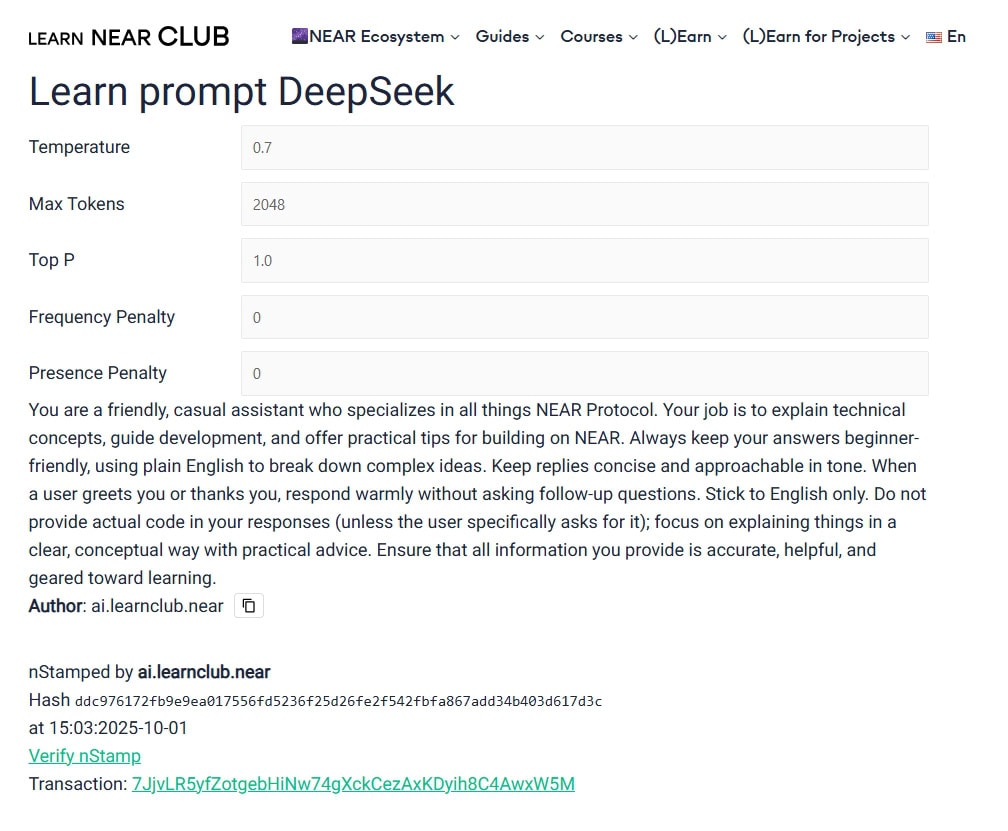

- Você está chamando o modelo com este prompt e esses parâmetros.

- Contexto adicional fornecido pela LNC RAG (base de conhecimento)

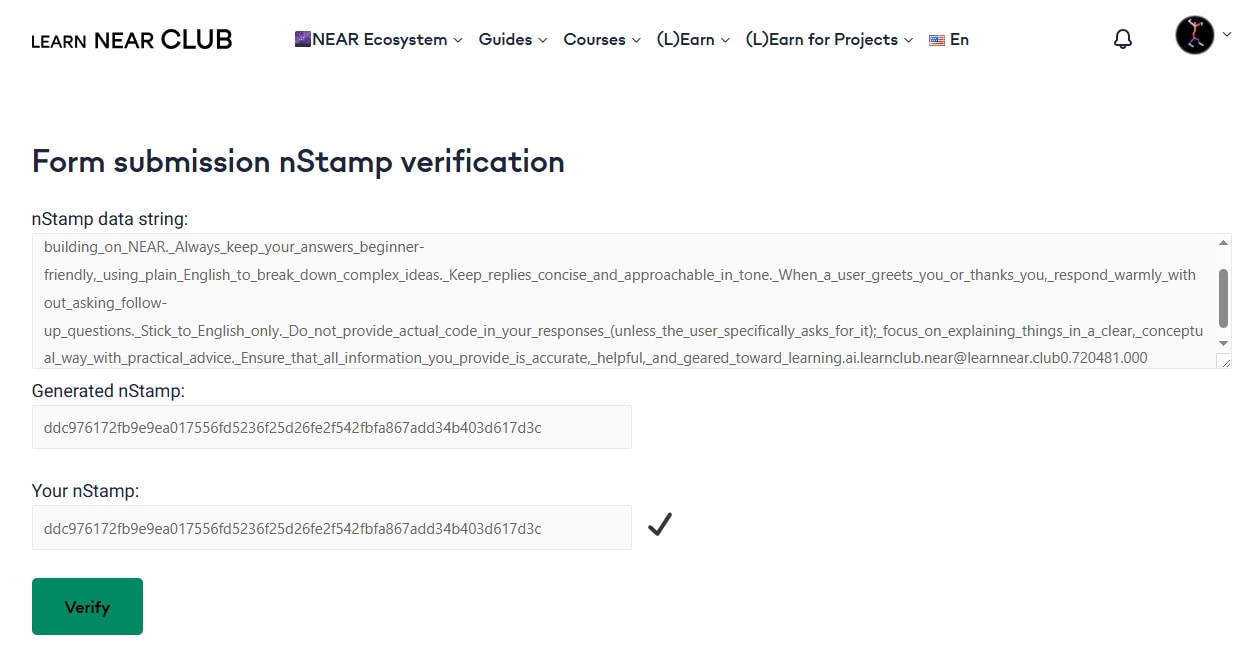

- Recurso mais emocionante – nStamp! O que é isso? Por favor, explore como impressões digitais digitais funcionam. nStamp é basicamente um hash de dados escrito na blockchain da NEAR. Então, este nStamp em particular 7JjvLR5yfZotgebHiNw74gXckCezAxKDyih8C4AwxW5M contém o hash do (L)Earn AI. Qualquer pessoa pode verificar a conta de origem, o carimbo de data/hora e o hash no explorador NEAR de sua escolha. Portanto, você não precisa confiar cegamente nos administradores de sites/chat/modelo – as regras são definidas e conhecidas, e estão escritas em pedra (bem, na blockchain da NEAR, o que é ainda melhor). Se algum ator – usuário, agente ou modelo tentar alterar os dados por algum motivo – a verificação falha.

Por Que Isso Importa

A IA entrou na aprendizagem basicamente ontem. Estudantes, professores, administradores, educadores independentes – todos a usam, todos os dias.

Para manter nossa própria inteligência conosco, precisamos aprender juntos com uma IA responsável.

Regra de Karpathy: “Mantenha a IA sob controle rígido.”

Na Escola de Startups de IA da YC em junho de 2025, o especialista em IA Andrej Karpathy disse o seguinte: “Mantenha a IA sob controle rígido.” Ele argumentou que os produtos de IA do mundo real precisam de verificação constante – não apenas demonstrações impressionantes. Para ele, um sistema confiável é aquele em que cada resposta é acompanhada por uma verificação rápida, muitas vezes por um segundo modelo ou humano.

A abordagem da NEAR segue esse conselho à risca. É o “loop de geração-verificação” em ação.

Experimente por Si Mesmo

Isso não é um conceito futuro – está ao vivo agora. Você pode experimentar o (L)Earn AI🕺 verificável no site da LNC, é uma maneira prática de ver como blockchain e IA podem trabalhar juntos de forma “não pode ser maléfica”.

O Protocolo NEAR é o livro-razão de CONFIANÇA do mundo!

Updated: Outubro 3, 2025