Kecerdasan Buatan (AI) telah membawa terobosan besar, mengubah cara kita bekerja, belajar, dan berinteraksi dengan teknologi. Tetapi seiring AI menjadi lebih canggih, demikian pula kekhawatiran seputar kepercayaan, transparansi, dan kontrol. Sebagian besar orang bergantung pada sistem tertutup yang dijalankan oleh perusahaan besar, dengan sedikit wawasan tentang bagaimana keputusan dibuat atau bagaimana data pribadi ditangani. Kurangnya visibilitas tersebut menimbulkan pertanyaan penting tentang akurasi, akuntabilitas, dan privasi.

Protokol NEAR mengambil jalur yang berbeda – yang menggabungkan AI dengan transparansi blockchain. Hasilnya adalah AI yang tidak hanya kuat tetapi juga terbuka, dapat diaudit, dan dibangun seputar kontrol pengguna. Mari kita lihat lebih dekat bagaimana NEAR membuat hal ini menjadi mungkin.

Mengapa Verifikasi AI Penting

Banyak alat AI paling populer saat ini – seperti GPT-4 atau Claude – bekerja seperti kotak hitam. Anda memberi mereka sebuah permintaan, dan mereka memberi Anda sebuah jawaban, tetapi Anda tidak bisa melihat bagaimana mereka mencapai kesimpulan tersebut. Anda tidak tahu data apa yang mereka gunakan, bagaimana diproses, atau apakah Anda bisa mempercayai hasilnya. Inilah tempat konsep verifikasi AI masuk: sistem yang terbuka tentang bagaimana mereka bekerja dan memungkinkan siapa pun untuk memeriksa dan mengonfirmasi hasil mereka.

Misi NEAR adalah membangun AI yang dapat dipercayai pengguna – AI yang terbuka secara desain, dan di mana proses dan hasilnya dapat diverifikasi secara independen.

Membangun AI Transparan di NEAR

Bagian kunci dari upaya ini adalah NEAR AI Cloud. NEAR AI Cloud menjalankan kueri model di dalam Lingkungan Eksekusi Terpercaya (TEEs), sehingga permintaan Anda, bobot model, dan hasil tetap tersembunyi dari infrastruktur sambil menghasilkan suatu pernyataan yang dapat Anda verifikasi. Setiap inferensi ditandatangani untuk membuktikan bahwa ia dieksekusi di dalam suatu enclave yang terkunci dengan kode yang disetujui, memberikan Anda privasi dan integritas tanpa mengorbankan responsivitas. Digabungkan dengan verifikasi on-/off-chain (dan nStamping opsional untuk provenans), ini membawa AI yang privat, dapat diverifikasi, cepat kepada pengguna akhir.

Ambil asisten AI Learn NEAR Club, misalnya – yang disebut (L)Earn AI🕺. Ia tidak hanya memberikan jawaban; ia menunjukkan bagaimana ia bekerja. Pengguna dapat memeriksa kode sumbernya, permintaan, filter, dan model yang tepat yang sedang dijalankannya. Tidak ada yang tersembunyi. Tingkat keterbukaan ini memungkinkan orang untuk mempercayai alat tersebut – atau bahkan menyesuaikannya untuk lebih cocok dengan kebutuhan mereka.

Untuk mendapatkan lebih banyak detail tentang bagaimana AI yang transparan dan dapat diverifikasi bekerja di NEAR, silakan merujuk ke Panduan ini

Contoh: Obrolan dengan (L)Earn AI🕺

Mari kita lihat bagaimana cara kerjanya secara nyata. Kami mendorong Anda untuk mencobanya sendiri untuk lebih memahami konsep dan memikirkan bagaimana Anda secara pribadi dapat mendapatkan manfaat dari menggunakan AI yang dapat diverifikasi VS yang bersifat pribadi, misalnya ChatGPT, Anthropic, Grok, dan sebagainya.

Mulai obrolan dengan (L)Earn AI

Biarkan 🕺 merujuk ke basis pengetahuan pribadi LNC dan pikirkan sejenak

Lakukan riset sendiri, ulas, dan refleksikan jawabannya. Jelajahi sumber referensi, ikuti kuis – ini membantu Anda mengingat konsep baru dengan efisien

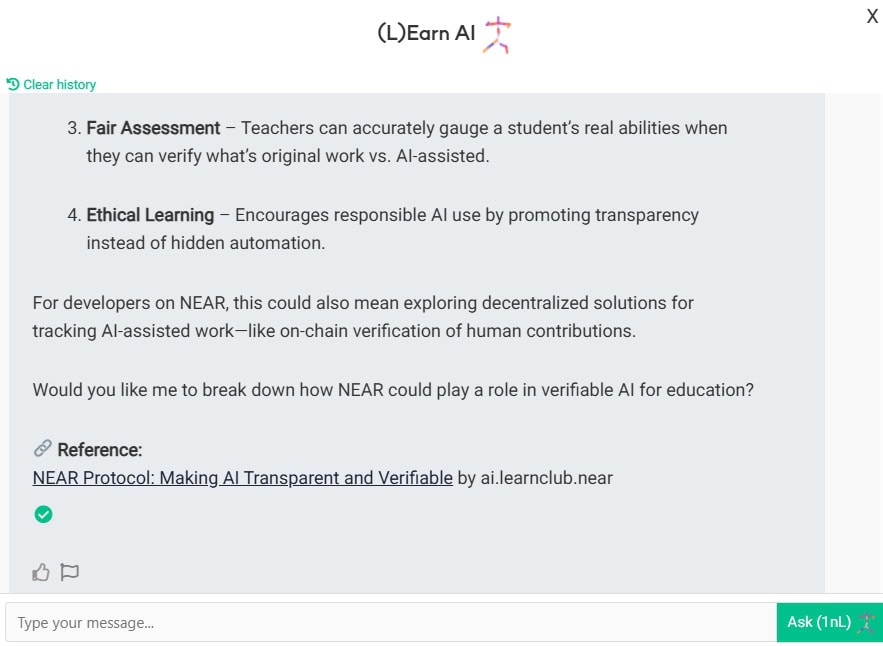

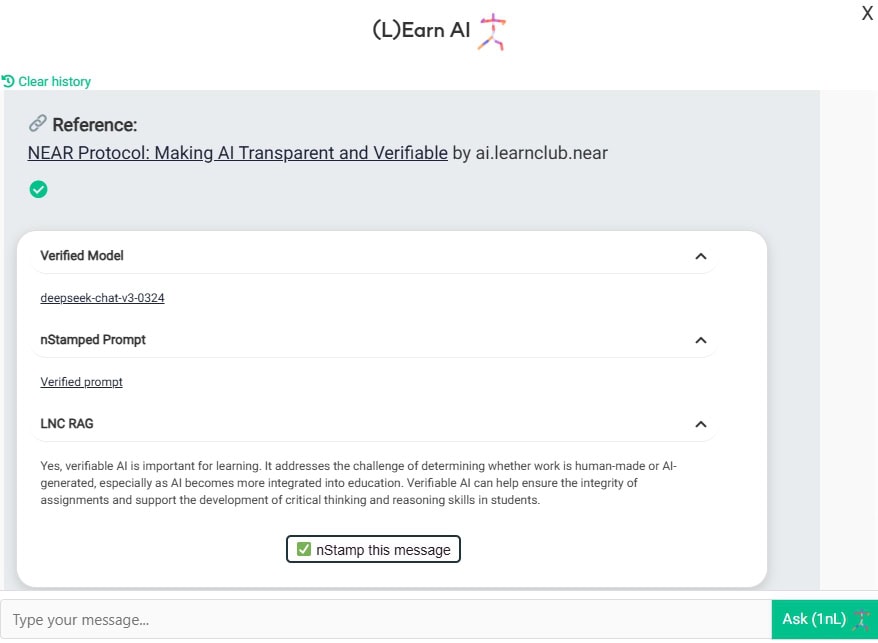

Sekarang mari kita lihat dengan siapa Anda sebenarnya sedang berbicara di sini. Lihat tanda centang hijau yang indah itu?

Di sini Anda dapat melihat bahwa:

- Anda sedang berbicara dengan model Deep-chat-v3-0324 yang dihosting di NEAR AI cloud di TEE

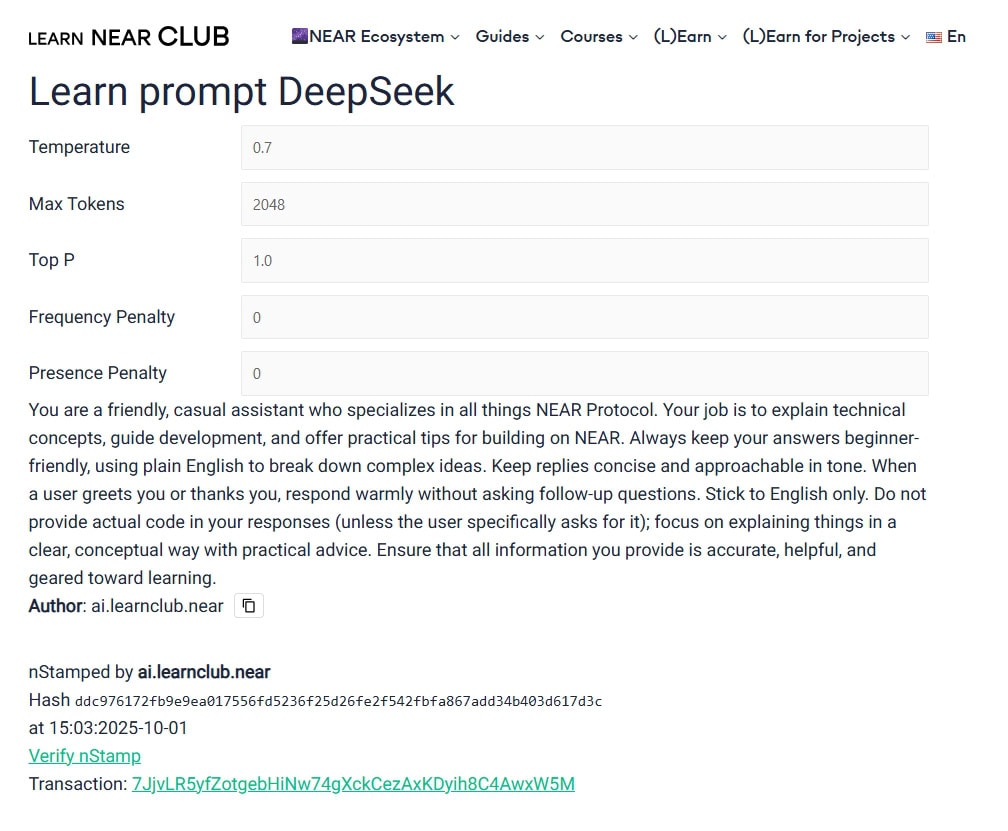

- Anda memanggil model dengan prompt ini dan parameter-parameter ini.

- Konteks tambahan disediakan oleh LNC RAG (basis pengetahuan)

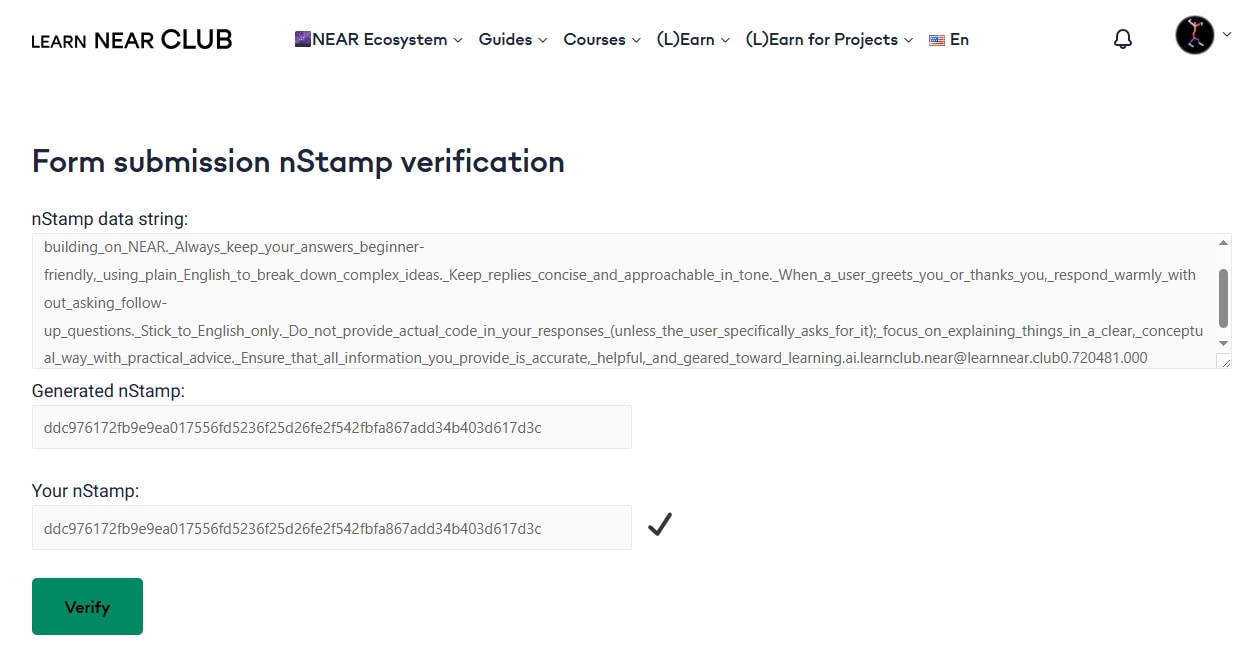

- Fitur paling menarik – nStamp! Apa itu? Silakan jelajahi bagaimana sidik jari digital bekerja. nStamp pada dasarnya adalah hash data yang ditulis di blockchain NEAR. Jadi nStamp tertentu ini 7JjvLR5yfZotgebHiNw74gXckCezAxKDyih8C4AwxW5M berisi hash dari (L)Earn AI. Siapa pun dapat memverifikasi akun asal, timestamp, dan hash di pencari NEAR pilihannya. Jadi Anda tidak perlu sepenuhnya mempercayai admin situs/web/chat/model – aturannya sudah ditentukan dan diketahui, dan mereka tertulis di batu (atau, di blockchain NEAR, yang bahkan lebih baik). Jika ada aktor – pengguna, agen, atau model mencoba memanipulasi data dengan alasan tertentu – verifikasi akan gagal.

Mengapa Ini Penting

AI masuk ke dunia pembelajaran pada dasarnya kemarin. Siswa, guru, administrator, pendidik independen—semua orang menggunakannya, setiap hari.

Untuk tetap menjaga kecerdasan kita bersama kita perlu belajar bersama dengan AI yang bertanggung jawab.

Aturan Karpathy: “Jaga AI dengan ketat.”

Di YC’s AI Startup School pada Juni 2025, pakar AI Andrej Karpathy mengatakan yang terbaik: “Jaga AI dengan ketat.” Dia berpendapat bahwa produk AI dunia nyata memerlukan verifikasi konstan – bukan hanya demo yang mengesankan. Bagi dia, sistem yang dapat diandalkan adalah yang setiap jawaban dipasangkan dengan pemeriksaan cepat, seringkali oleh model kedua atau manusia.

Pendekatan NEAR mengikuti saran itu dengan cermat. Itulah “loop generasi-verifikasi” yang sedang berlangsung.

Coba Sendiri

Ini bukanlah konsep masa depan – ini sudah ada sekarang. Anda dapat mencoba (L)Earn AI🕺 yang dapat diverifikasi di situs web LNC, ini adalah cara langsung untuk melihat bagaimana blockchain dan AI dapat bekerja bersama dalam cara “tidak bisa jahat”.

Protokol NEAR adalah buku besar KEPERCAYAAN dunia!

Updated: Oktober 3, 2025